投稿者: 筑波大学計算科学研究センター

庄司助教、堀助教らが量子生命科学会 第二回大会で優秀発表賞を受賞

冬眠するブラックホール 〜銀河衝突がもたらす大質量ブラックホールのエネルギー源の流失~

令和3年1月26日

国立大学法人 東京大学

国立大学法人 筑波大学

公立大学法人 尾道市立大学

大学共同利用機関法人 自然科学研究機構 国立天文台

発表のポイント

◆銀河中心の大質量ブラックホールの活動性の活性化・不活性化の起源を、銀河の衝突現象と結びつけることで、世界で初めて解明しました。

◆小さな銀河が大きな銀河に衝突してブラックホール周辺の物質を剥ぎ取ってしまうことで、ブラックホールの活動を停止させる場合もある事を証明しました。

◆本研究はブラックホールと銀河の相互の進化解明のマイルストーンとなることが期待されます。

概要

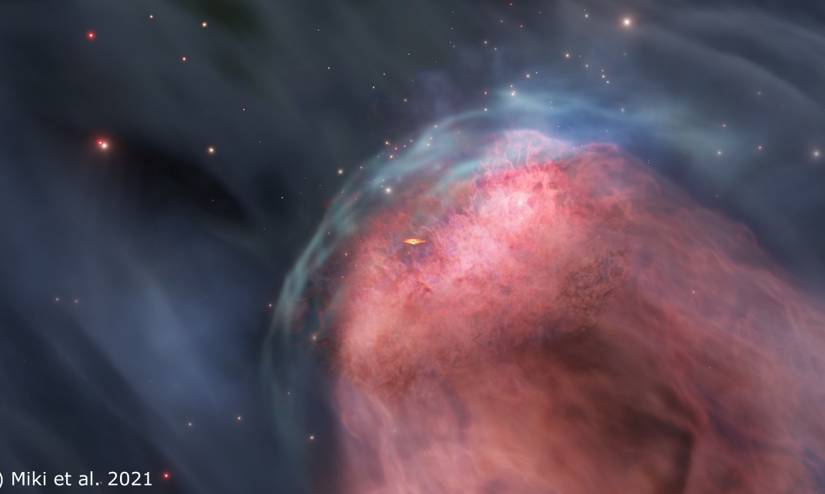

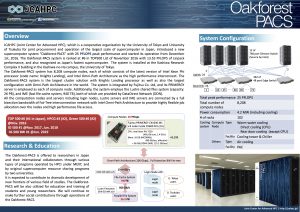

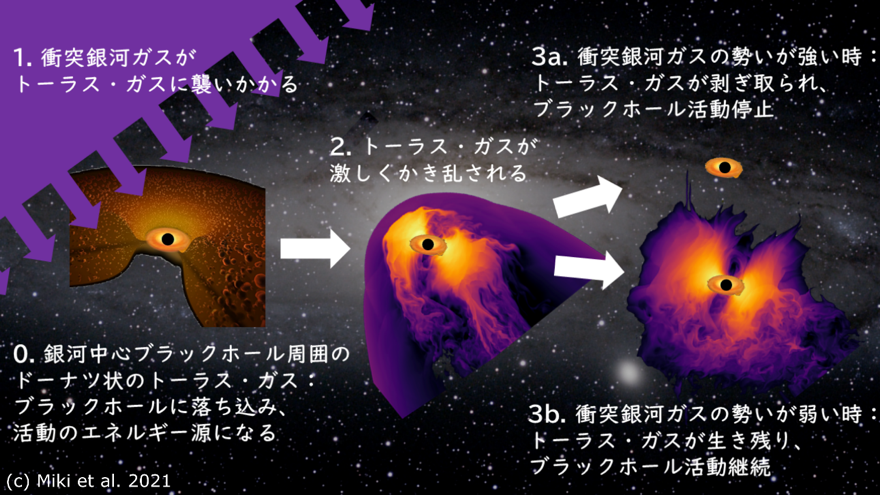

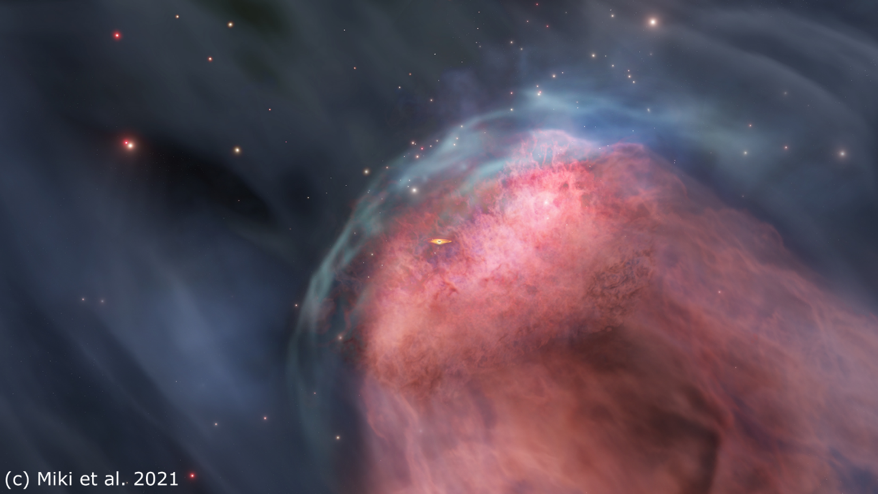

宇宙には太陽の質量の10万倍を超える大質量ブラックホール(注1)があまねく存在しますが、そのごく一部は落ち込む物質をエネルギー源にして明るく輝き激しく活動しているものの、ほとんどは銀河の中心でひっそりと佇んでいます。こうしたブラックホールの活動と休眠の間の状態変化をつかさどるメカニズムが未解明である中、東京大学情報基盤センターの三木洋平助教、筑波大学計算科学研究センターの森正夫准教授、尾道市立大学経済情報学部/国立天文台の川口俊宏准教授の研究グループは、Oakforest-PACS(オークフォレストパックス、注2)等のスーパーコンピュータを駆使し、銀河衝突と銀河中心ブラックホールの活動性の謎を世界で初めて明らかにしました。

銀河中心ブラックホールは、これまで銀河衝突により激しく活動すると信じられてきました。衝突によって銀河円盤の物質が中心に落下し、ブラックホールに落ち込むことでその活動にスイッチが入ります。しかし銀河衝突が中心で起こった場合、事態は全く異なります。矢が正鵠を射ぬくがごとく、中心に衝突した銀河がブラックホール周辺のガスを持ち去ってしまい、エネルギー源を失ったブラックホールは活動を停止し静かに眠りにつくのです(図1、図2)。

本研究が明らかにしたブラックホール活動性の休眠メカニズムは、最近の観測によって見つかった、銀河中心ブラックホールの活動が急停止した兆候を示す新種族の天体群との関連もうかがうことができ、天文学最大の謎の一つである、銀河の進化に伴う銀河中心ブラックホールの形成解明へのマイルストーンとなることが期待されます。

重田教授らの研究成果がJournal of Physical Chemistry の表紙に選ばれました

東京大学大学院新領域創成科学研究科物質系専攻の佐々木裕次教授、産業技術総合研究所 先端オペランド計測技術オープンイノベーションラボラトリバイオ分子動態チーム 三尾和弘 ラボチーム長、藤村章子特別研究員、筑波大学計算科学研究センター生命科学研究部門 重田育照教授らの研究グループは、熱や痛みの伝達を司る TRP チャネルの 1 分子内部運動を、マイクロ秒オーダーで実時間計測することに世界で初めて成功し、 この研究成果が the Journal of Physical Chemistry の表紙に採用されました。

the Journal of Physical Chemistry

(研究成果についてプレスリリース「『熱』や『痛み』を感じるタンパク質の小さい動きを高速キャッチ! -体に優しい鎮痛薬開発のための新たな創薬指針の提案へ- 」をどうぞ)

2021年度筑波大学計算科学研究センター「学際共同利用」公募(締切1/24)

2021年度筑波大学計算科学研究センター「学際共同利用」プログラムの公募が始まりました。

詳しくは学際共同利用のページをご覧ください。

奮ってのご応募をお持ち申し上げます。

公募締切:2021年1月24日(金)

HPCIオープンセミナー 「スーパーコンピュータとCOVID-19」(要事前申込)

2021年1月19日、一般財団法人高度情報科学技術研究機構(RIST)の主催による、COVID-19に関するセミナーが開催されます。

発生から1年経ってもなお世界的に猛威を振るっているCOVID-19に対して、HPCIは今年4月から「新型コロナウイルス感染症対応HPCI臨時公募課題」の募集行っており、計算科学研究センターのCygnus、JCAHPCのOakforest-PACSも利用されています。今回、この取り組みを広く知っていただくために、HPCIを利用した研究について紹介するとともに、スーパーコンピュータの社会貢献と今後の可能性について一般の方向けに座談会形式のセミナーが開催されることとなりました。

研究者、計算科学に興味のある方、学生まで幅広い方の参加をお待ちしております。

セミナー特設ページ(外部リンク)

概要

【開催日】 2021年1月19日(火)13:30-15:40

【開催形式】Webexによるオンライン開催

【主 催】一般財団法人高度情報科学技術研究機構(RIST)

【参加費】無料 (事前にお申し込みが必要です。)

【プログラム】

<座談会>

「社会を支えるスーパーコンピュータ~HPCI fights against COVID-19~」(動画放映)

<講演>

・Covid-19関連タンパクに対するインシリコリポジショニング

(筑波大学計算科学研究センター 重田 育照)

・分子動力学シミュレーションで見るCOVID-19ウイルスのRNAポリメラーゼとその阻害薬

(分子科学研究所 奥村 久士)

・Nanoporeシーケンサと深層学習を用いた新型コロナウィルスRNA修飾の解析

(東京大学先端科学技術研究センター 上田 宏生)

※開催内容は変更となる場合があります。

【申込方法】WEBページ(https://fugaku100kei.jp/events/20210119/)より申込み

【申込締切】1月15日(金)

【問合せ】

一般財団法人高度情報科学技術研究機構

神戸センター HPCIオープンセミナー事務局 (event[at]hpci-office.jp [at]→@)

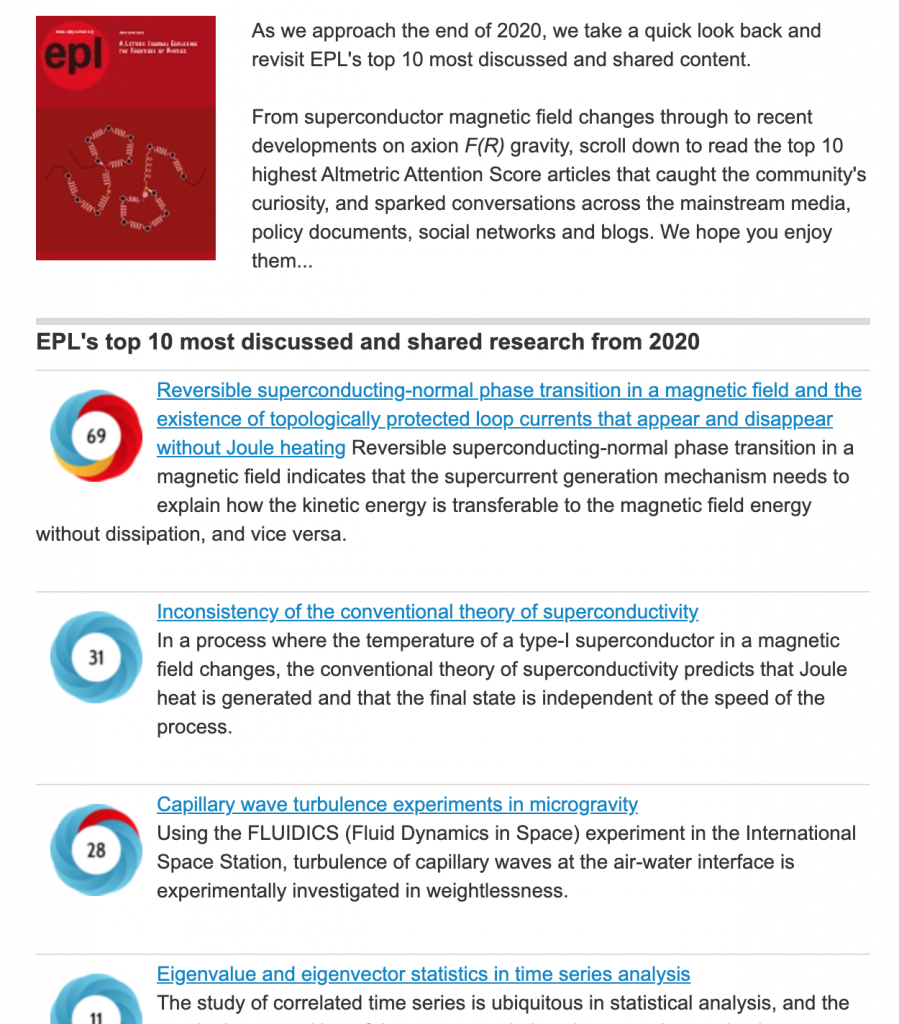

小泉 裕康 准教授の論文が、EPL’s top 10 most discussed and shared research from 2020 に選ばれました

量子物性研究部門 小泉 裕康 准教授の論文が、EPL’s top 10 most discussed and shared research from 2020 に選ばれました。

これは物理学の全ての分野をカバーする学術誌 EPL に今年掲載された論文のうち、ニュース、ブログ、SNSなどを通じて最も話題となった論文をランキングしたもので、小泉准教授の成果は幅広いメディアに取り上げられ、第1位にランクインしています。

論文発表時の日本語版プレスリリース:「なぜ、超伝導電流は電気抵抗なしで消えるのか? 〜磁場中での超伝導-常伝導相転移を説明する新理論〜」 (2020.8.22)

GENESIS講習会−Cygnusを用いたハンズオン−

2021年1月29日(金) 13:30~17:30 web講習会 (要事前申込)

GENESIS (GENeralized-Ensemble SImulation System)は理化学研究所で開発されている分子動力学(MD)計算ソフトウェアです。特に生体高分子(タンパク質、核酸、糖鎖など)を対象としています。また独自の高速化、並列化手法を持つため、効率の良い計算手法が利用でき、富岳などのスーパーコンピュータからGPU計算機、インテル計算機まで対応しています。今回の講習会では、GENESISによる生体高分子のMDにご興味がある方を対象に、筑波大学計算科学研究センターのCygnusを利用して実際のシミュレーションに触れていただきながら、講習を行います。初めてGENESISを利用される方の参加も歓迎いたします。

講習会終了後、フリーディスカッションの時間を設けております。GENESISの利用方法などにご興味がある方は、この機会にぜひ、ご参加ください。

関連リンク:HPCI セミナー情報ページ

開催概要

| 日時 | 2021年1月29日(金)13:30~17:30 (13:00接続開始) |

| 場所 |

筑波大学計算科学研究センターワークショップ室、または、web会議システム BlueJeansを使用したオンライン参加

*講師はオンラインでの参加になります。 *新型コロナウィルスの影響により、講習会当日にワークショップ室を使わず、オンラインのみの開催になる場合もございます。あらかじめご了承ください。 |

| 受講資格 |

|

| 参加費 | 無料 |

| 定員 | 12名程度(先着順) |

| 受講の際の注意事項 |

以下について事前にご確認ください。

→ 当日は、CygnusへSSH接続するためのノートパソコンをお持ちください。

→ 事前に接続の可否をご確認ください。

→ オンラインのみで参加される方はBlueJeansアプリを用いた接続をお願いします。事前に接続の可否をご確認ください。

→ ハンズオンでは、Linuxを使用します。基本的なコマンドの使い方(cat、ls、cd、pwd、cp、tar)を事前にご確認ください。

*Linux初心者向けの簡単な資料も用意しています。受講者の方には、他の資料と同様に配布いたします。

→ ハンズオンでは、簡単にテキストファイルの編集を行っていただきます。テキストエディタとして、viあるいはEmacsを使用していただきますので、基本的な使い方を事前にご確認ください。

|

プログラム

2021年1月29日

| 13:30-13:45 | 事務局からのお知らせとBlueJeansの機能説明 |

| 13:45-14:20 | GENESISの概要 |

| 14:20-14:50 | Cygnusの紹介、GENESISのCygnusでのジョブ実行方法 |

| 14:50-15:10 | <休憩> |

| 15:10-16:30 | GENESISでのMD計算ハンズオン、もしくはデモ |

| 16:30-17:30 | フリーディスカッション |

講師

岩橋千草氏(理化学研究所計算科学研究センター)

Jaewoon Jung氏(理化学研究所計算科学研究センター)

松岳大輔氏(高度情報科学技術研究機構)

主催・共催

| 主催: | 筑波大学計算科学研究センター |

| 共催: | 一般財団法人 高度情報科学技術研究機構 |

講習会資料

本講習会で使用するテキストは、当日に配布いたします。

お願い

- 受講の際の注意事項をよくご確認ください。

- 講習会終了後、アンケートにご協力をお願いします。

受講申込

申込フォームからお申し込みください。メールでのお申し込みは受け付けておりません。

申込締切は 2021年1月19日(火) 17:00 とさせていただきます。

定員に達しましたら、お申し込みを締め切らせていただきます。

ご質問・お問い合わせ

hpci-workshop[-at-]hpci-office.jp ([-at-]は@にしてください)までお問い合わせください。

「熱」や「痛み」を感じるタンパク質の小さい動きを高速キャッチ!

-体に優しい鎮痛薬開発のための新たな創薬指針の提案へ-

東京大学大学院新領域創成科学研究科物質系専攻の佐々木裕次教授、産業技術総合研究所先端オペランド計測技術オープンイノベーションラボラトリバイオ分子動態チーム 三尾和弘ラボチーム長、藤村章子特別研究員、筑波大学計算科学研究センター生命科学研究部門 重田育照教授らの研究グループは、熱や痛みの伝達を司るTRPチャネル(注1)の1分子内部運動を、マイクロ秒オーダーで実時間計測することに世界で初めて成功しました。

ヒト及び多様な動物種の複数の感覚刺激の応答に関与することで知られるTRPチャネルは、4つのサブユニット(注2)から構成され、細胞膜を24回貫通する分子です。最近、詳細な分子構造が決定され、研究が一層加速され注目を集めています。TRPチャネルを活性化させるカプサイシンを添加した実験では、チャネルを開けてイオンを流す動きは、右回りのねじれ運動を伴い、またチャネルを阻害する薬剤を添加した実験では、それと逆向きに左回りのねじれ運動を検出しました。さらにカプサイシンが反応しない変異体TRPチャネルを使った実験では、阻害する薬剤を加えた時と同様にチャネルの運動を抑える左回りのねじれ運動が検出されました。このようにさまざまな条件下でリアルタイムにダイナミックな動きを検出することに成功しました。また、これらの動きがすべて数十pm2/msという極めて小さい拡散定数(注3)で動いていることも判明しました。

本研究グループが用いた計測法は「X線1分子追跡法(Diffracted X-ray Tracking: DXT)」(注4)と呼ばれるもので、金ナノ結晶でラベルされた部位における分子内部動態を1分子動画として検出します。この実験は兵庫県西播磨にある大型放射光施設SPring-8の BL40XU(注5)で行われました。DXTは従来の分子構造決定や反応ポケットの構造解析だけからは得られない、分子の動きに着目した新しい創薬技術の開発への貢献が大いに期待されます。

この成果の詳細は物理化学領域において長い歴史のある国際誌Journal of Physical Chemistryに掲載され、本研究のイメージ図が表紙に採用される予定です。なお、雑誌掲載に先立ち、同誌Webサイトにて、2020年12月9日にオンライン公開されました。

SALMON講習会 (要申し込み 1月28日)

−全国共同利用大規模並列計算システムOCTOPUSを用いたハンズオン−

2021年1月28日(木) 13:30~17:30 web講習会

SALMONは、光と物質の相互作用で起こる多様なナノスケールの電子ダイナミクスに対して第一原理計算を行うオープンソース計算プログラムです。 計算は時間依存密度汎関数理論に基づいており、ノルム保存擬ポテンシャルを含む時間依存コーンシャム方程式を実時間・実空間で解きます。光電磁場の伝搬を記述することも可能です。今回の講習会は、SALMONを用いて光と物質の相互作用を計算することに興味のある方を対象に、SALMONの背景となる基礎理論と計算法の簡単な説明を行ったのち、大阪大学サイバーメディアセンターの全国共同利用大規模並列計算システムOCTOPUSを用いて実際にSALMONを用いた実習を行います。理論の研究者だけではなく、実験研究者や企業研究者、大学院生のご参加を歓迎いたします。

詳細および受講申し込みはこちら (外部リンク)

開催概要

| 日時 | 2021年1月28日(木)13:30~17:30 (13:00接続開始) |

| 場所 |

web会議システム Zoomを使用したWeb講習会

|

| 受講資格 |

|

| 参加費 | 無料 |

| 定員 | 10名程度(先着順) |

| 受講の際の注意事項 |

以下について事前にご確認ください。

事前に接続の可否をご確認ください。

Zoomアプリを用いた接続をお願いします。事前に接続の可否をご確認ください。

ハンズオンでは、Linuxを使用します。基本的なコマンドの使い方(cat、ls、cd、pwd、cp、tar)を事前にご確認ください。

*Linux初心者向けの簡単な資料も用意しています。受講者の方には、他の資料と同様に配布いたします。

ハンズオンでは、簡単にテキストファイルの編集を行っていただきます。テキストエディタとして、viあるいはEmacsを使用していただきますので、基本的な使い方を事前にご確認ください。

|

Next Step in Simulating the Universe

Researchers led by the University of Tsukuba devise a new approach to show how ghost-like neutrinos helped shape the Universe

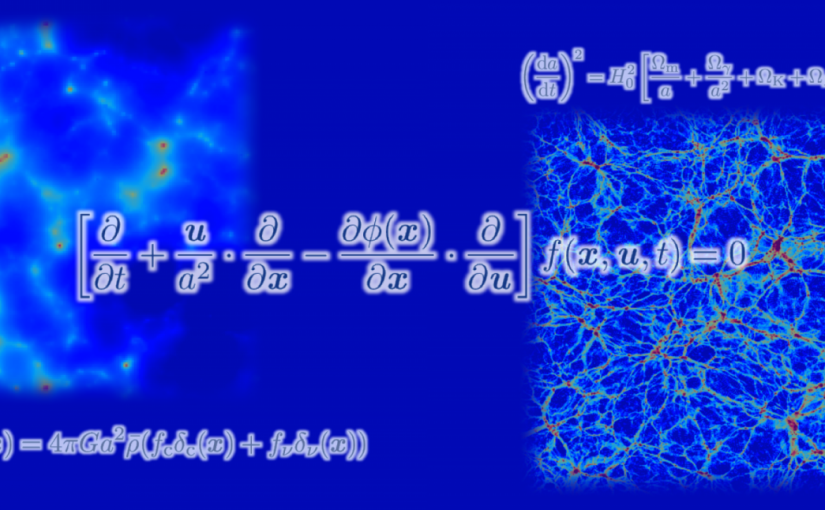

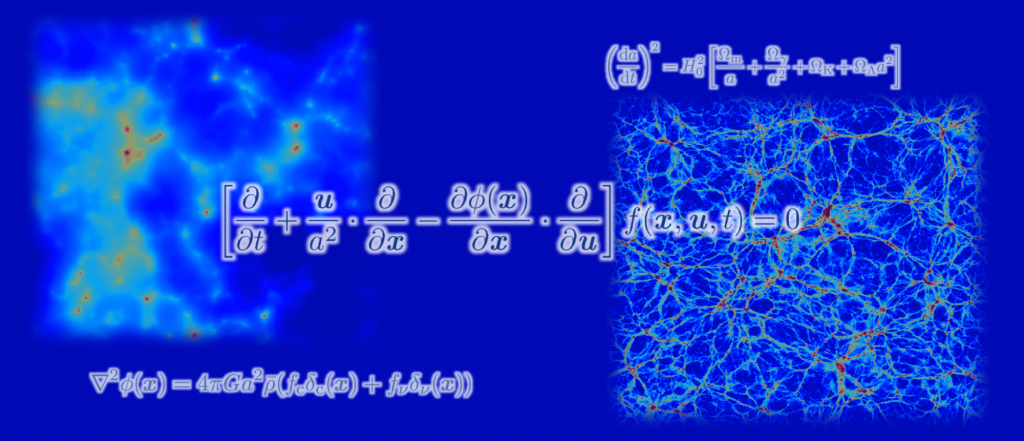

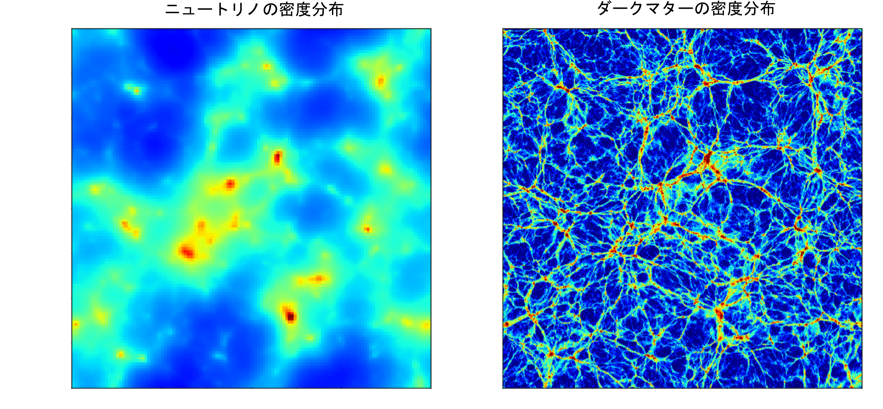

Tsukuba, Japan – Computer simulations have struggled to capture the impact of elusive particles called neutrinos on the formation and growth of the large-scale structure of the Universe. But now, a research team from Japan has developed a method that overcomes this hurdle.

In a study published this month in The Astrophysical Journal, researchers led by the University of Tsukuba present simulations that accurately depict the role of neutrinos in the evolution of the Universe.

Why are these simulations important? One key reason is that they can set constraints on a currently unknown quantity: the neutrino mass. If this quantity is set to a particular value in the simulations and the simulation results differ from observations, that value can be ruled out. However, the constraints can be trusted only if the simulations are accurate, which was not guaranteed in previous work. The team behind this latest research aimed to address this limitation.

“Earlier simulations used certain approximations that might not be valid,” says lead author of the study Lecturer Kohji Yoshikawa. “In our work, we avoided these approximations by employing a technique that accurately represents the velocity distribution function of the neutrinos and follows its time evolution.”

To do this, the research team directly solved a system of equations known as the Vlasov–Poisson equations, which describe how particles move in the Universe. They then carried out simulations for different values of the neutrino mass and systemically examined the effects of neutrinos on the large-scale structure of the Universe.

The simulation results demonstrate, for example, that neutrinos suppress the clustering of dark matter—the ‘missing’ mass in the Universe—and in turn galaxies. They also show that neutrino-rich regions are strongly correlated with massive galaxy clusters and that the effective temperature of the neutrinos varies substantially depending on the neutrino mass.

“Overall, our findings suggest that neutrinos considerably affect the large-scale structure formation, and that our simulations provide an accurate account for the important effect of neutrinos,” explains Lecturer Yoshikawa. “It is also reassuring that our new results are consistent with those from entirely different simulation approaches.”

This work represents a milestone in simulating the Universe and paves the way for further exploration of how neutrinos influence the formation and growth of the large-scale structure. For instance, the new simulation approach could be used to study the dynamics of neutrinos and unconventional types of dark matter. Ultimately, it might lead to a determination of the neutrino mass.

Original Paper

The article, “Cosmological Vlasov–Poisson Simulations of Structure Formation with Relic Neutrinos: Nonlinear Clustering and the Neutrino Mass,” was published in The Astrophysical Journal at DOI: 10.3847/1538-4357/abbd46

Correspondence

Assistant Professor YOSHIKAWA Kohji

Center for Computational Sciences, University of Tsukuba

宇宙を飛び交うニュートリノの動きを明らかに ~世界初の6次元シミュレーションに成功~

物質を構成する基本的な素粒子の一つであるニュートリノは我々の宇宙に大量に存在し、わずかながら質量を持つことが知られています。しかし、その質量は、地上の素粒子実験などでは測定が困難で、未解明の謎として残っています。一方、宇宙における天体や物質の分布(大規模構造)の詳細な観測からニュートリノの質量を測定できることが近年の宇宙進化の理論によって示され、大型観測プロジェクトが世界中で計画されています。

理論的には、精緻な数値シミュレーションにより宇宙の大規模構造を詳細に再現することが必要ですが、そのためには、多次元空間中での素粒子の集団的な運動を記述する「ブラソフ方程式」を解かなくてはなりません。この難解な方程式を解くためには膨大な計算時間やコンピュータの記憶容量が必要なため、これまではニュートリノの分布を仮想的な粒子の分布に置き換え、近似的な解を得ることしかできませんでした。しかしこの方法では、再現された宇宙の物質分布に人工的な数値ノイズが混入するという大きな問題があります。

本研究では、筑波大学と東京大学が新たに開発したブラソフ方程式の高精度計算手法と、国内を代表するスーパーコンピュータを組み合わせることによって、ブラソフ方程式を直接解き、宇宙を高速で飛び交うニュートリノの6次元数値シミュレーションを行うことに、世界で初めて成功しました。これにより、ニュートリノの集団的な運動の様子を正確に調べることができるようになり、ニュートリノの質量を正確に測定するための理論モデルの構築が可能となりました。

論文はこちら

原田准教授、佐藤助教が筑波大学若手教員奨励賞受賞

【すぐわかアカデミア。】動画公開

国立大学共同利用・共同研究拠点協議会が2020年4月より動画配信している「知の拠点【すぐわかアカデミア。】」の No.15 として、筑波大学計算科学研究センターの動画が公開されました。

高性能計算システム研究部門の藤田助教協力のもと、スーパーコンピュータCygnusやCygnusを使った研究などを8分弱の動画で紹介しています。

[webリリース]超巨大ブラックホールから吹く「風」の謎を解明

宇宙物理研究部門の大須賀教授が参加した研究グループの成果が、国際学術誌「Monthly Notices of the Royal Astronomical Society」に掲載されました。

概要引用

宇宙には数多くの銀河があり、その中心には超巨大ブラックホールが存在しています。ブラックホールは周りにあるガスを次々に吸い込んでいきますが、なかにはブラックホールに吸い込まれずに、外に向かって高速で吹き出すガスも存在します。強い重力源であるはずのブラックホールから重力に逆らって「風」が吹き出すのは、一見不思議な現象です。このような「風」の存在はこれまでの X 線観測から知られていましたが、どうやって吹いているのかについてはまだ分かっていませんでした。京都大学白眉センター/理学研究科の水本岬希 特定助教を中心とする国際研究グループは、X 線の擬似観測によって実際に観測されている「風」の様子を 定量的に再現し、ブラックホールの周りで生み出される紫外線の力によって「風」が生まれるということを世界で初めて実証しました。今後は、2022 年度に日本で打ち上げが予定されている XRISM 衛星を使うことで、 風の様子をこれまでにないほどはっきりと捉えることができると期待されます。 本成果は 2020 年 11 月 19 日に英国の国際学術誌「Monthly Notices of the Royal Astronomical Society(王立天文学会月報)」にオンライン掲載されました。

論文タイトル:UV line driven disc wind as the origin of ultrafast outflows in AGN

著 者:Misaki Mizumoto, Mariko Nomura, Chris Done, Ken Ohsuga, Hirokazu Odaka

掲 載 誌:Monthly Notices of the Royal Astronomical Society

DOI:10.1093/mnras/staa3282

[Oakforest-PACS] ネットワーク伝送路工事による通信中断 (11/30)

東京大学情報基盤センター(柏)およびJCAHPC(最先端共同HPC基盤施設)の

スーパーコンピュータの外部接続用ネットワーク伝送路を収納する設備に影響する、

国道6号道路改良工事のため以下の日時に通信が中断します。

日時:2020年11月30日(月) 午前3:00 ~ 午前4:00(実断60分以内)

Oakforest-PACS のログインノード、インタラクティブジョブ等をご利用の際はご注意ください。

SC20 Virtual Exhibition

Welcome to our webpage!

Center for Computational Sciences, University of Tsukuba (CCS) is a multidisciplinary research center for advanced HPC and natural science researches.

Want to ask a researcher directly?

We will open six meeting rooms on Zoom for your questions and discussion. Zoom URL will open here 5min before the meeting.

【Meeting Hour: 17th Nov. 10:00am-11:00am EST】

【Meeting Hour: 17th Nov. 7:00pm-8:00pm EST】

【Meeting Hour: 18th Nov. 10:00am-11:00am EST】

【Meeting Hour: 18th Nov. 7:00pm-8:00pm EST】

【Meeting Hour: 19th Nov. 10:00am-11:00am EST】

【Meeting Hour: 19th Nov. 7:00pm-8:00pm EST】

Video

180° Camera Tour of CCS

180° Camera Tour of Cygnus

Our New Supercomputer Cygnus

Research Posters

- Mission & Chronology of CCS

- Supercomputer at CCS: Cygnus

- Particle Physics

- Astrophysics

- Nuclear Physics

- Quantum Condensed Matter Physics

- Biological Function and Information

- Molecular Evolution

- Global Environmental Science

- High Performance Computing Systems 1

- High Performance Computing Systems 2

- Database

- Computational Media

- Supercomputer Oakforest-PACS

- Application on Oakforest-PACS

Give Away

The distribution period is over.

Report of the Review Committee & CCS Reports for Review

Contact

pr[at]ccs.tsukuba.ac.jp

Back to SC20

> Back to our SC20 Virtual Booth

格子QCD数値シミュレーションのゲージ配位データをDOI登録開始

素粒子に働く強い相互作用を数値的に研究する格子量子色力学(QCD)では、大規模な数値シミュレーションによって「ゲージ配位」と呼ばれるデータが生成され、これを基にして陽子や中性子などハドロンと呼ばれる粒子の質量や反応過程などを計算することができます。大きな計算機資源を使って作られたこのゲージ配位データを共有しようという目的で作られたのがILDG (International Lattice Data Grid)や、その日本でのグリッドであるJLDG (Japan -) です。JLDGは国内の研究機関を結ぶ高速ネットワークの上に築かれたデータグリッドで、格子QCDを含む計算物理のインフラストラクチャ-として重要な役割を果たしています。

JLDGでは国内の研究グループが生成したゲージ配位のデータを公開しています。このたび、これらのデータにDOI (Digital Object Identifier) を登録する仕組みを整備し、最初のゲージ配位データに対するDOI登録が完了しました。

詳しくは以下のページをご覧ください

計算基礎化学連携拠点(JICFuS): 格子QCD数値シミュレーションのゲージ配位データをDOI登録開始

GPUコンピューティングことはじめ

額田 彰 教授

高性能計算システム研究部門

額田教授は、スーパーコンピュータ等の最先端計算機システムを効果的に活用してさまざまな計算の高速化を実現することを目的とした高性能計算の研究者です。

(2020.11.9 公開)

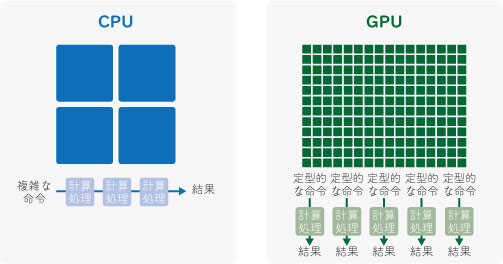

GPUとは

GPU(Graphics Processing Unit)は本来グラフィックス処理専用のデバイスです。計算処理はCPUが担当し、可視化処理などだけがGPUに分担され、そのままディスプレイに出力されるのが一般的でした。パソコン用のゲームが普及していった結果、より高解像度のきれいな画像生成をより高速に行う需要が増え、それに応えるためGPUの処理速度が飛躍的に向上していきました。GPUが行う画像処理は定型的で、画面の各ピクセルの値(色)を計算するために同等の処理を多数、別個のデータに対して行うという性質があります。

このため演算器の数を増大させることがCPUよりずっと容易なアーキテクチャになっており、いつのまにか32bitの浮動小数演算性能において当時のCPUを上回っていました。また多数の演算器にデータを送る必要があるためGPUは少ない容量ながらも専用のメモリを搭載し、そのデータ転送速度はCPUのメインメモリを超えるようになりました。

GPUによる汎用計算

GPUがCPUより高い演算性能を持つとわかるとGPUを計算に使いたくなるものです。元々GPUはグラフィックス処理しかできない構造でしたが、グラフィックス分野も急激に進歩し、GPUのハードウェアも処理内容を詳細にプログラム可能になってきて、2000年代後半ついに、汎用計算向けのプログラム開発環境がGPUベンダーから提供されるようになりました。

これまで様々な計算がGPUプログラムに移植されて高速化を実現しています。しかしどのような計算でもよいわけではなく、「同等の処理を多数」実行するというハードウェアの基本に合わせなければ意味がありません。CPUは多くても数十コアを搭載しているものが主流ですが、GPUのコア数は数千規模でさらにその何倍もの並列性がなければ演算器をフルに活用することができません。提供されているプログラミング言語もこれを想定したものになっていて、その型にはまるようにうまく記述できるような計算内容であればGPUで高速化できることが多いと言えます。

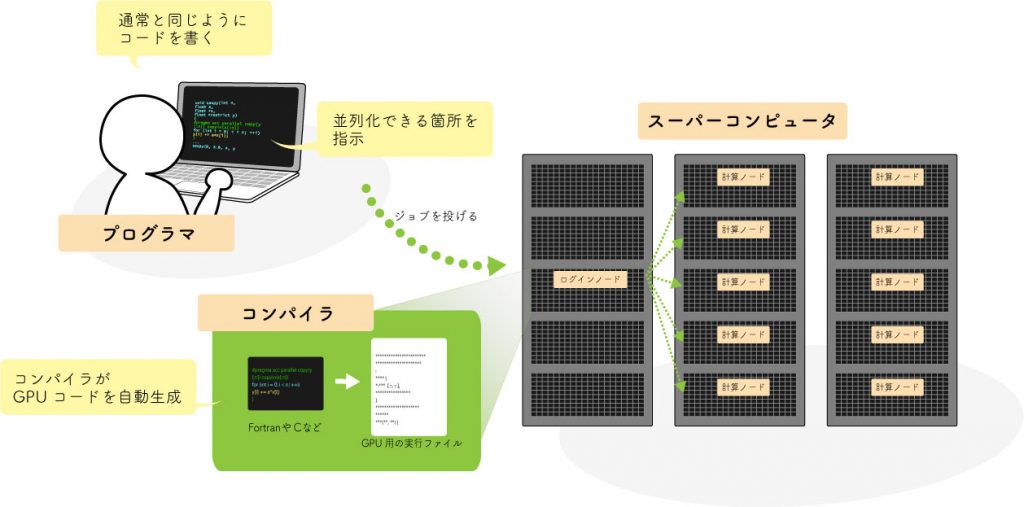

CPU用のプログラムをGPUに移植すると、今後CPU用とGPU用の2つのコードを管理し続けなければなりません。計算内容がもう変わることがないのであれば問題ありませんが、最先端研究で使用されているソフトウェアは頻繁に更新され続けることが多くなっています。そこで近年需要が高まっているのがOpenACCやOpenMPのような、指示詞(コメント文)によるGPU化の方法です。プログラマはコードの中で並列性が高くGPUで高速化可能な箇所を指示し、コンパイラがGPU用のコードを生成してくれます。コンパイラの負担が非常に大きいのですが、これによってCPU用とGPU用の両方の実行プログラムをコンパイラのオプションの切り替えのみで生成でき、コードの管理が楽になります。

今後

現在、世界トップ500のスパコンの中にはCygnusを含め多数のGPU搭載システムがあります。これはGPUがすでに汎用計算用のプロセッサとして広く受け入れられていることを示し、またコストパフォーマンスや電力効率においても優れていることもシステム調達の検討時に大きなポイントになっているようです。

さらに詳しく知りたい人へ

- HPCS研究室ホームページ

計算機の顕微鏡で生体分子の「形」と「動き」を解き明かす

原田 隆平 准教授

生命科学研究部門 生命機能情報分野

生体内では、タンパク質や核酸のような生体分子が様々に形を変えながら機能しています。原田准教授は、こうした生体分子の形や動きをシミュレーションするために、効率の良い計算手法の開発研究を行っています。

(2020.11.4 公開)

計算機の“顕微鏡”で見える世界

生体内では様々な生体分子が機能しています。生体分子を構成している原子は絶えず振動していて、静電気力や化学結合といった周囲の原子や分子との間に働く力によって相互に作用し、時に構造の変化が起こります。原子の振動はフェムト秒(1000兆分の1秒、フェムトは10の-15乗)のスケールで起きていますが、タンパク質が機能するための構造の変化にはマイクロ秒(100万分の1秒、マイクロは10の-6乗)以上もの時間がかかります。このような原子・分子にとってとても長い時間がかかる現象のことを、「レアイベント」と呼びます。

タンパク質の構造を解明するためには、タンパク質の結晶をX線で観察するX線結晶解析などの方法が使われています。しかしこうした実験的手法では、実際の生体内部での構造変化をリアルタイムに観測することはできません。そこで、実際に構造がどのように変化していくのかを調べるために用いられている方法が、分子動力学シミュレーション(molecular dynamics: MD)です。

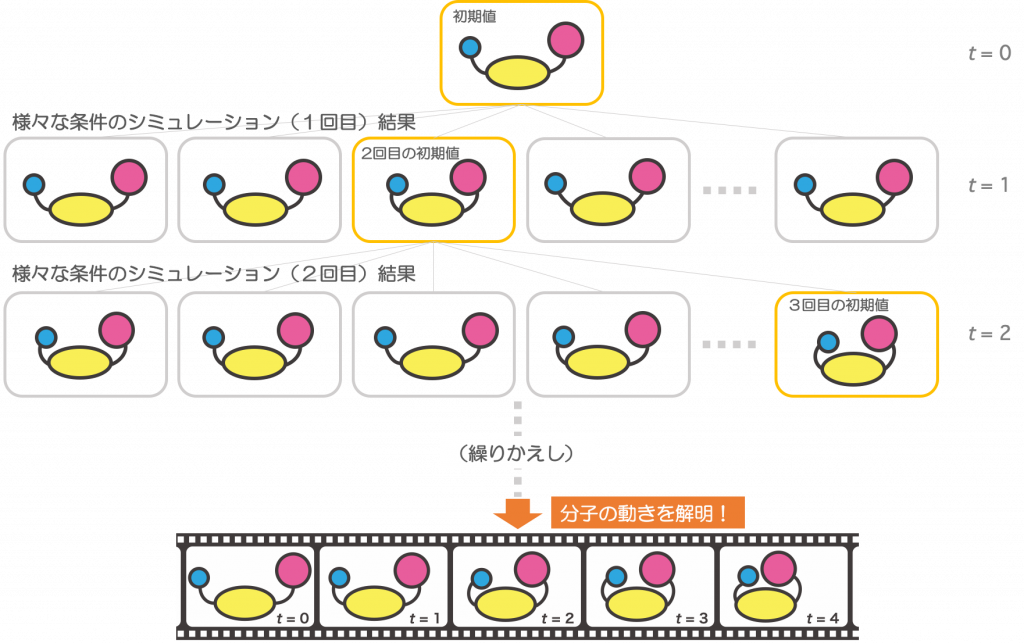

MDでは、まず調べたい構造の最初の状態として原子・分子の位置を設定し、それぞれの原子・分子が周辺の原子・分子からどのような力を受けるのか、その結果、どのように運動するのかを計算します。これを繰り返すことで、パラパラ漫画のように分子が動いていく様子を調べることができます(図1)。まさに、計算することで分子の動きを見る“顕微鏡”です。

MDでは、全ての原子・分子について計算を行う必要があります。当然、調べたい分子の大きさが大きくなって原子数が増えるほど、また、調べたい時間が長くなるほど、計算量や計算にかかる時間は膨大になります。実際にスーパーコンピュータの計算性能があっても、マイクロ秒以上かかるようなレアイベントを一度に計算するのはとても困難です。

そこで、原田准教授は新しい計算手法を考案しました。

まれにしか起こらない “レアイベント” を捉えるために

レアイベントは確率的に起こります。シミュレーションで扱う時間を長くしても起きないこともあれば、時間が短くても起きる場合もある、という点に原田准教授は着目しました。

そこで、ピコ秒(1兆分の1秒、ピコは10の-12乗)という非常に短い時間についてのシミュレーションを同時にたくさん、いろいろな条件で動かし、その中でより目的のものに近づいた結果を次のシミュレーションの初期値として、もう一度いろいろな条件で計算をする、というセットを繰り返す方法を開発しました(図2)。こうすることで、計算によるレアイベントの検出にかかる時間を1,000倍以上短くすることが可能になりました。

この計算方法のポイントは、同時にたくさんの同じような計算をするところにあります。こうした計算は並列型のスーパーコンピュータの得意分野です。原田准教授はCygnusなどのスーパーコンピュータを使いながら、着目する生体分子の状況や特性に合わせたいろいろな種類の計算手法を開発し、アプリケーションを進めています。

これまでの研究では、計算の効率を格段にあげることに成功してきました。これからは、使う人のニーズに応えながら、より使いやすいアプリケーションとして公開していくための研究を進めてく段階です。

今は、分子の形が目的のものに近付いたかどうかを判定する指標である「反応座標(注1」を、使う人が経験的に決めるしかありません。人が決めることで恣意的になり、エラーや人による違いも出てしまいます。最適な反応座標を自動的に決めることができれば、「完全な構造変化の予測」に繋がるはずです。

恣意性が入らない完全な構造変化の予測、それが原田准教授の目指す究極のシミュレーションの形です。研究室では、次のステップに向けた研究が始められています。

【用語】

1)反応座標:生体分子の構造変化を特徴付ける物理変数で、分子間の距離や結合角度などの情報が使われる。どのような要素を反応座標として用いるのが最適かは取り扱う生体分子によって異なる。

さらに詳しく知りたい人へ

- タンパク質の柔らかな運動を誘起する分子シミュレーション(日本語総説: 生物物理54(3) , 167-171, 2014)

塩川浩昭准教授の研究課題が「さきがけ」に採択

- JST 戦略的創造研究推進事業における2020年度第1期新規研究課題の決定について https://www.jst.go.jp/pr/info/info1460/index.html

- 採択者情報 https://www.jst.go.jp/kisoken/presto/application/2020/201019/201019.html