2023年10月13日

国立大学法人 筑波大学

東京医科大学

整形外科手術ではX線透視画像を頻繁に使用しますが、術中に、2次元情報である画像から患部の3次元形状を正しく認識することは困難です。この問題を解消するため、あらかじめ取得した患部の3次元CTデータを、術中のX線透視画像上に全自動で正確に重ね合わせる技術を開発しました。

概要

X線透視装置は、整形外科手術において頻繁に使用される医療機器ですが、2次元のX線画像から患部の3次元形状を対応付けるには、医師の経験や知識に多くを頼っているのが現状です。術中に撮影するX線画像と、術前にCTスキャンで取得した3次元モデル(CTモデル)との重ね合わせができれば、医師自身が2次元画像から3次元形状を想像する作業が軽減され、手術に集中できるようになります。このような目的でX線画像とCTモデルを高精度に重ね合わせる際には、「身体の一部だけを大写しした画像(局所画像)でも機能すること」「全自動で処理できること」が不可欠です。そこで本研究では、X線画像のシーン座標を回帰する畳み込みニューラルネットワーク(CNN)を用いて、これらを実現しました。X線撮影カメラの光学中心と画像中の画素を結ぶ直線と、CTモデルとの交点で、シーン座標を定義し、その座標系で3次元点群とその観測位置(2次元座標)の対応関係を自動的に取得可能な手法を考案するとともに、これにより獲得した対応点情報と深層学習を組み合わせることで、局所画像に対しても高精度な重ね合わせに成功しました。

本技術を、骨盤のCTモデルとX線画像の両方が収録されているデータセットを用いて検証した結果、シミュレーションX線画像で3.79mm(標準偏差1.67mm)、実写X線画像で9.65mm(標準偏差4.07mm)の誤差で、X線画像とCTモデルの重ね合わせを達成しました。

研究代表者

筑波大学 計算科学研究センター

北原 格 教授

Pragyan SHERESTHA(エンパワーメント情報学プログラム3年)

東京医科大学 茨城医療センター

吉井 雄一 教授

研究の背景

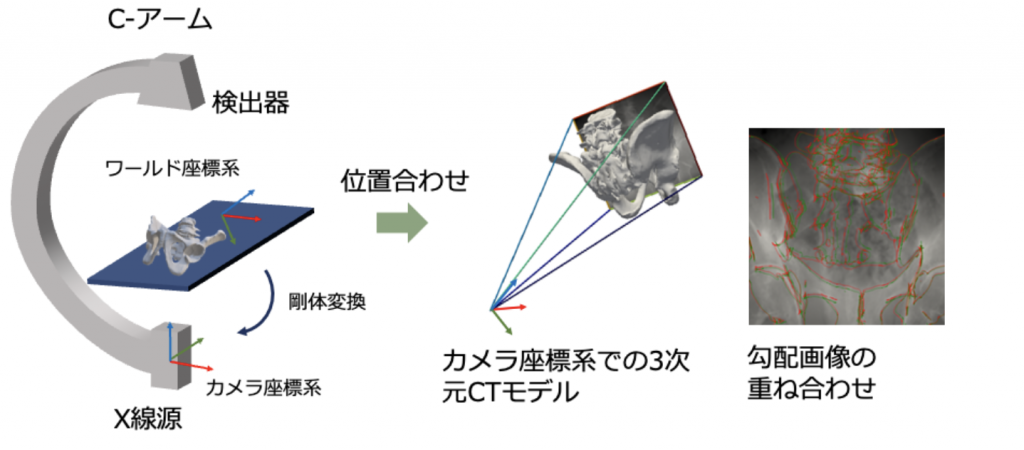

画像支援は、現代の外科手術において重要な役割を果たしています。整形外科の分野では、人工関節置換術注1)、脊椎固定術、骨接合術注2)など、多くの手術で術中X線透視画像が利用されています。しかしながら、2次元のX線画像内では、撮影対象の解剖学的構造が重なり合って見えるため、画像のみから実際の患部の3次元構造を正しく認識することは困難です。術中に撮影するX線画像と、術前に取得した患部の3次元CT(コンピュータ断層撮影)データとを正確に重ね合わせる(図1)ことができれば、医師自身が3次元構造を想像する作業が軽減され、手術に集中できるようになります。

このような高精度な重ね合わせを行う一般的な手法では、患者の術部に放射線不透過性マーカーを埋め込み、術前に3次元CTデータを取得してそれぞれの画像でマーカーを特定し、術中に撮影する画像との対応関係を求めます。しかし体内にマーカーを埋め込むにはコストがかかる上、手術部以外の侵襲を伴います。そこで、マーカーを使わない手法が研究されてきました。その中でも、近年注目されているのがX線画像からランドマーク点注3)を特定する深層学習ベースの手法です。骨形状上の解剖学的なランドマーク点をX線画像から推定することで、高精度な重ね合わせを可能とするものですが、撮影姿勢によっては、あらかじめ設定したランドマーク点が写らないことがある、また、深層学習モデルの学習時に、ランドマーク点にラベル付けする作業(アノテーション)が必要となる、などの課題があります。本研究では、これらの課題を、シーン座標注3)の推定を行うことで解決しました。

研究内容と成果

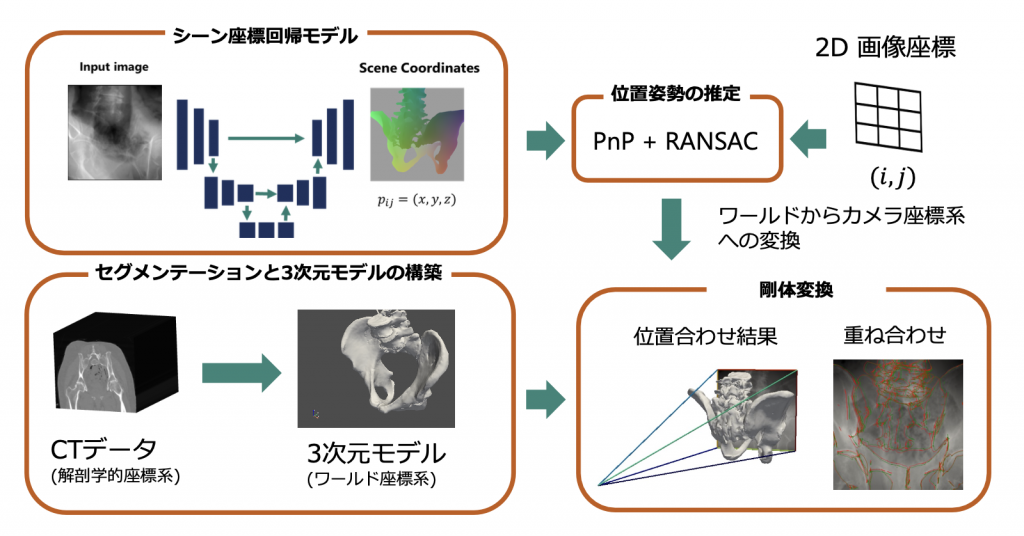

術中に用いる撮影カメラの光学中心と画像中の画素を結ぶ直線と、術前にCTスキャンで取得した3次元モデル(CTモデル)との交点で、シーン座標を定義し、その座標系で3次元点群とその観測位置(2次元座標)の密な対応関係(画像上のピクセルごとに3次元の座標値を対応させる)を自動的に取得可能な手法を考案しました。また、この手法により獲得した対応点情報と深層学習を組み合わせることで、局所画像に対しても高精度な重ね合わせに成功しました。

具体的には、X線画像からその対象物体の表面のシーン座標を回帰するモデルを開発しました。この方法の特徴は、畳み込みニューラルネットワーク(CNN)注4)を用いることで、推定するシーン座標を入力した画像の各画素と対応させる点です。先行研究における位置合わせ手法では数箇所の対応しか作れないのに対し、本手法では密な対応が作れます。ここで、シーン座標系は3次元CTデータにおいて定義されているため、X線画像を撮った際に、その画像とCTデータの相対的な関係を求めることができます(図2)。これによって明示的にランドマーク点注5)のアノテーションを行う手間が省かれ、さらに、骨形状が写っている限り対応点が得られるため、ランドマーク点を含まない局所画像についても重ね合わせができるようになります。

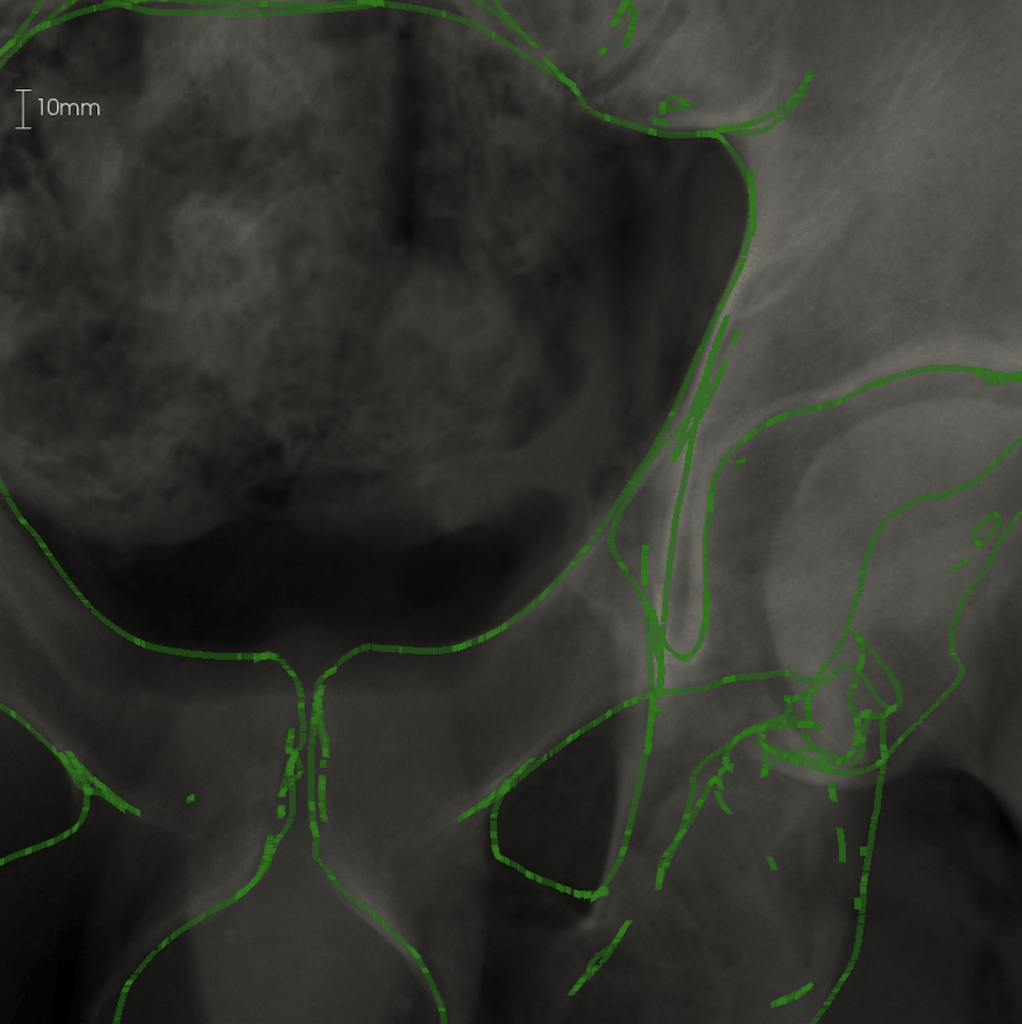

実験では、患者のCTデータからシミュレーションで生成したX線画像を使って、シーン座標を回帰する深層学習モデルを学習させました。その際、さまざまな撮影姿勢を設定した他、実際のX線画像のような見た目を再現するモデルDeepDRR注6)を用いました。その結果、シミュレーション画像でのテストでは、推定された位置姿勢と実際の位置姿勢には平均で3.88mmの誤差が確認されました。また、10mm以下の誤差を重ね合わせの成功基準とした場合、失敗率は平均で11.76%にとどまりました。また、シミュレーション画像で学習したモデルを実際のX線画像に適用したところ、画像上の誤差9.65mmの精度で重ね合わせができました(図3)。

今後の展開

本手法で得られた重ね合わせを初期値として、X線画像のシミュレーションと実際のX線画像の差分を最小化するように最適化を実行することで、さらなる精度向上が期待できます。なお本手法では、密な2次元と3次元の対応を推定する際に、重ね合わせに用いる対応点の最適な組み合わせを選ぶための計算回数が増え、実行時間が単位画像あたり2秒程度と、他の手法と比べて100倍程度長くかかります。今後、推定したシーン座標の信頼度を工夫して重ね合わせに用いる対応点を絞り込むことで高速化を図り、医療現場での実証実験を進める予定です。

参考図

図3 本手法による実際のX線画像での重ね合わせ結果の例 左図と右図はそれぞれ異なる患者の骨盤に対する画像処理の結果を示し、いずれも、左側が3Dモデル、右側がX線画像に勾配画像(緑の線)を重ね合わせたもの。X線画像内の骨領域(画像の白い部分)の境界と勾配画像が精度良く重なっていることが確認できる。

用語解説

注1) 人工関節全置換術

けがや疾患によって傷んだ関節の表面を取り除いて、人工関節に置き換える手術。

注2) 骨接合術

骨折した部分を、プレートとスクリュー、髄内釘といわれる骨内の心棒を使って固定させる方法。

注3) シーン座標

3Dモデルの表面位置を記述する座標。

注4) 畳み込みニューラルネットワーク(CNN)

AIの学習手法の一つ。 画像を格子状に分割し、それぞれの特徴を画像全体にわたって比較し、一致の程度でフィルターをかける畳み込み処理を複数の層で行い、それらを結合することにより、一部が不明瞭な画像でも解析を可能にする。

注5) 解剖学的なランドマーク点

腸骨の前面上部に位置する上前腸骨など、異なる人体間で共通する特徴的部位。

注6) DeepDRR

CTデータからX線透視撮影画像のような見た目の画像を生成する技術。

注7) ワールド座標系

全ての座標の基準となる座標系。本システムではCT撮影時に観測機材によって定義される座標系。

注8) 剛体変換

物体形状は変化しない(剛体である)ことを前提に、3次元空間中での回転と平行移動を表現する変換。

注9) 勾配画像

画像の濃淡変化を勾配量として構成される画像。本システムでは、3次元モデルを投影した画像の濃淡変化を勾配値とした画像。物体境界付近は濃淡変化が大きいため強い勾配が現れる。

注10) U-Net

畳み込みニューラルネットワークの一種で、畳み込み処理によって入力画像を特徴量に変換するエンコーダ部分と、生成された特徴量から出力画像を生成するデコーダ部分から成る。

注11) Random Sample and Consensus

数理的なモデルのパラメータをデータから推定する際に、外れ値を除外するためのアルゴリズム。本研究においては、間違った対応点を除外するために用いた。

研究資金

本研究は、科研費による研究プロジェクト(23K08618)および日本損害保険協会交通事故医療研究助成の一環として実施されました。

【題 名】 X-Ray to CT Rigid Registration Using Scene Coordinate Regression

【著者名】 Pragyan Shrestha (University of Tsukuba) , Chun Xie (University of Tsukuba), Hidehiko Shishido (University of Tsukuba), Yuichi Yoshii (Tokyo Medical University), Itaru Kitahara (Universiy of Tsukuba)

【掲載誌】 The 26th International Conference on Medical Image Computing and Computer Assisted Intervention (MICCAI 2023)

【掲載日】 2023年10月1日

【DOI】 10.1007/978-3-031-43999-5_74