稼働中の計算機システム

現在、稼働中の計算機システムは、計算科学研究センター「Pegasus」および「Cygnus」です。

最新の運用状況についてはこちらをご確認ください。

Pegasus

Pegasusに搭載される演算加速装置(GPU)は、倍精度浮動小数点演算における理論ピーク性能が51 TFlopsであり、CPUと高帯域幅のPCIe Gen5により世界で初めて接続されます。DDR5メモリ、不揮発性メモリを搭載し、大容量メモリまたは超高速ストレージとしての利用が可能です。また、ネットワークについても最新の400Gbpsネットワークプラットフォームを利用します。

Pegasusは120ノードの計算ノードで構成され、全体の理論ピーク性能は6.5 PFlopsです。筑波大学計算科学研究センターは、共同利用・共同研究拠点として、学際共同利用、HPCI共同利用、一般利用などの各種利用プログラムにより、Pegasusを全世界のユーザに提供し、さらなる計算科学の発展に寄与します。

—> 詳細はこちら (2023.1.11 CPUも含む理論ピーク性能を公開しました / 2023.2.6 一部差し替えました)

—> プレスリリースはこちら

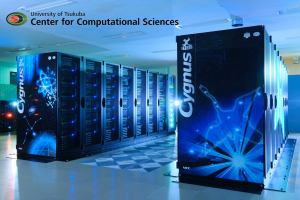

Cygnus

計算科学研究センターではこれまでGPU、many-core等のアクセラレータ付きクラスタによる超高速演算加速スーパーコンピュータを導入して来ました。many-coreスーパーコンピュータとしてIntel Knits Cornerカードを搭載したクラスタCOMAは2019年3月末をもって運用を終了します。このプログラムや利用技術は筑波大学・東京大学共同運用によるOakforest-PACS (Intel Knights Landingプロセッサによる超並列クラスタ)に引き継がれています。また、GPUクラスタHA-PACS及びHA-PACS/TCAはそれぞれ2018年3月、2018年10月をもって運用が終了しました。

同センターでは、次世代のスーパーコンピュータとして、GPUクラスタの技術を踏襲しつつ、さらなる新技術の開発とアプリケーションプログラム開発を目指し、GPUに加え超高性能FPGAを併せて搭載する計算ノードを持つ新スーパーコンピュータCygnusを導入することになりました。Cygnusの全ノードは4台の最新型GPUを備え、さらに全ノードの半分弱のノードにはこれらに加え2台の最新型FPGAを搭載します。

GPUとFPGAの混載により、これまでGPUだけでは効率的な計算が難しかったアプリケーションの性能を高め、またこれからの時代のstrong scaling並列処理に対応する演算加速技術の確立を目指すことを目的とし、Cygnusクラスタの運用を行います。

–> 詳細はこちら

Cygnusの紹介ムービーをこちらで見ることができます。

過去に稼働していた計算機システム

Oakforest-PACS

Oakforest-PACSは2022年3月に運用を終了いたしました。

Oakforest-PACSシステムは、米国Intel Corporationによる超高性能メニーコア型プロセッサである次世代インテルXeon Phiプロセッサ(開発コード名:Knights Landing)と、 同社による新型の相互結合ネットワークであるインテル Omni-Path アーキテクチャを搭載した計算ノードを、8,208台搭載した超並列クラスタ型スーパーコンピュータであり、同プロセッサを搭載した大規模システムとしては国内初となります。システム製作は富士通株式会社が行い、同社がHPC専用に開発する次期PRIMERGYサーバが計算ノードとして採用されます。さらに26 PByteの並列ファイルシステム、940 TByteの高速ファイルキャッシュシステム(共に米国DataDirect Networks社製)等が設置され、 総ピーク演算性能として「京」コンピュータの約2.2倍の超高性能システムとなります。 システムのピーク性能は25 PFLOPS以上、メモリ容量900 TByte以上です。 全ノード及び並列ファイルシステムのサーバはインテル Omni-PathネットワークをFat Tree結合した、フルバイセクションバンド幅を提供する相互結合網で結合され、計算ノードおよび共有ファイルシステムを柔軟かつ高効率で利用可能です。 さらに、SSDを搭載した高速ファイルキャッシュシステムにより、特に高いファイル入出力性能を求めるアプリケーションにも対応します。

Oakforest-PACSについてのより詳しい情報は、下記をご覧ください。

Oakforest-PACSについて Oakforest-PACS[JCAHPC:外部ページ]

COMA(PACS-IX)

COMAは2019年3月に運用を終了いたしました。

COMA (Cluster Of Many-core Architecture processor) は、本センターで研究開発が続けられてきたPACSシリーズの第9世代のスーパーコンピュータで、2014年4月より稼働を開始しました。従来のマルチコアCPUのコア数を大幅に増強し、次世代の高性能プロセッサとして注目されているメニーコア型プロセッサIntel Xeon Phiを演算加速装置として搭載した、HA-PACSに次ぐ演算加速装置付き超並列クラスタで、全計算ノード数は393台、理論ピーク演算性能は1.001Pflopsです。同システムは2014年6月のTop 500リストにおいて51位にランクされ、Intel Xeon Phiプロセッサを搭載したスーパーコンピュータとして日本最高性能のシステムとなりました。各計算ノードはIntel E5-2680v2 CPUを2台と、Intel Xeon Phi 7110Pコプロセッサを2台搭載し、InfiniBand FDRネットワークによるfull-bisectionバンド幅のFat Tree構成で全ノードが結合され、ここにRAID6ディスク装置によるLustreファイルシステム1.5 PByteが備えられています。システム全体はCray社のCS300クラスタシステムによって実装されています。

本センター及び東京大学情報基盤センターが共同運用する最先端共同HPC基盤施設では、メニーコアプロセッサ技術に基づく超並列スーパーコンピュータの導入・運用を開始する計画で、COMAにおけるメニーコアプロセッサ利用技術と経験を活かし、同システム上で超高性能計算科学アプリケーションの開発を進める予定です。

COMAについてのより詳しい情報は、下記をご覧ください。

密結合並列演算加速機構実証システム「HA-PACS」

HA-PACSベースクラスタシステムは2017年3月、HA-PACS/TCAは2018年10月に運用を終了いたしました。

HA-PACSベースクラスタシステムはCPUとGPUの両方に最新の技術を用いた大規模並列GPUクラスタで、わずか268ノードで 802 Tflopsの理論ピーク性能を実現しています。同システムは2012年6月のTop 500リストにおいて41位にランクされました。各計算ノードとしてはIntel E5-2680 CPUを2台とNVIDIA社Tesla M2090 GPUを4台、高密度搭載したAppro International社(現Cray社)のGreenBlade 8200シリーズを用いています。全ての計算ノードは2系統のInfiniBand QDRx4リンクを持ち、full-bisectionバンド幅を持つFat-Treeにより接続されています。

2013年11月、HA-PACSベースクラスタを拡張する形でHA-PACS/TCAが稼働開始しました。TCA (Tightly Coupled accelerators)は、GPU等の演算加速装置を計算ノードを跨いで直接結合する、本センターが独自に提唱するアーキテクチャで、FPGA実装によって実現したPEACH2 (PCI Express Adaptive Communication Hub ver.2)で実装されています。各計算ノードにはIntel E5-2680v2 CPUを2台とNVIDIA社K20X GPUを4台の他、PEACH2によるTCA通信ボードが装着され、最小2.1μ秒での超低レイテンシ遠隔GPU間通信が可能です。HA-PACS/TCAは364 Tflopsの理論ピーク性能を持ち、Linpack電力性能値 3518 Mflops/Wを実現、2013年11月のGreen500 リストにおいて世界第3位にランクされました。また、ベースクラスタ部とInfiniBandネットワークで結合され、HA-PACS全体では1.166 Pflopsのピーク性能を実現し、本センターとして初めてのPflops級スーパーコンピュータとなりました。

HA-PACS/TCAの紹介ムービーをこちらで見ることができます。

T2K-Tsukuba

T2K-Tsukubaは、2014年2月に運用を終了いたしました。T2K-Tsukubaシステムは、大容量メモリと高密度実装された高性能CPUからなる計算ノード、そしてそれらを最大限に活用する超高速相互結合網からなる大規模PCクラスタです。

各計算ノードは、4つの2.3GHzのquad-core AMD Opteronプロセッサ(合計16コア)と32GBのDDR2 SDRAMメモリからなります。様々な高性能並列計算のために、全計算ノードは4本の平行結線された4X DDR Infinibandネットワークによる相互結合網で結合されています。システム全体は、648台の計算ノードを5.28TB/sのフルバイセクションバンド幅を持つFat-Tree型相互結合網で結合した単一クラスタとして構成されており、10,368個のCPUコアにより95.4TFLOPSの理論ピーク性能と20.7 Tbyteの総メモリ容量が提供されます。

各計算ノード上の16コアのCPU間では、共有メモリによるマルチスレッド並列処理が可能です。さらに、分散メモリ結合される最大648台の計算ノードをメッセージパッシング通信によって利用することにより、様々な最先端計算科学諸問題に適用可能なシステムが提供されます。また、偏りのないフラットなFat-Tree型相互結合網の導入により、高い効率の並列処理と柔軟なジョブアロケーションが実現されます。

T2K-Tsukubaシステムは、2008年6月のTOP500リストにおいて世界第20位にランクされました。本システムは、本学・東京大学・京都大学の3大学間で結ばれたT2Kオープンスーパーコンピュータ提携に基づき導入されたものです。共通基本構造を持つ2大学のT2Kシステムと共に高速広域ネットワークを通じてグリッド運用することが可能となっています。

複合型並列計算機 「宇宙シミュレータFIRST」

FIRSTは運用を終了しています。FIRST は、256ノードからなるヘテロジニアス構成の並列計算機であり、Intel Xeon CPUを搭載したPCクラスタに、 新規に開発された重力計算専用ボード「Blade-GRAPE」がPCI-Xバスを介して組み込まれています。

ピーク性能は専用機部分 33TFLOPS、汎用機部分 3.1TFLOPSで、インターコネクトは多ポートギガビットスイッチによる一様ネットワーク構成となっています。

オペレーティングシステムはLinuxで、プログラミングはFORTRAN90及びC、C++により行っています。

FIRSTはクラスタサーバー内に専用機を組み込むことにより、新世代型の並列計算機アーキテクチャを実現しています。

さらに詳しく知りたい方はFIRSTプロジェクトをご覧下さい。

高性能超並列クラスタ 「PACS-CS」

PACS-CSは、2011年9月30日にシャットダウンいたしました。後継の「HA-PACS」を2012年2月から運用開始しました。

PACS-CSは、プロセッサとネットワークの両者にコモディティ技術を駆使し、新規開発された独自のノードとネットワーク構成を持つ計算科学向け超並列クラスタです。高い演算性能を持つことに加え、単体PU性能・メモリ性能・結合網性能のすべての面でバランスのとれた高性能並列処理能力を備えています。

理論ピーク性能14.3TFLOPS、総主記憶容量は5.12Tbyteです。システムは、2560台の演算ノード (ピーク性能 5.6GFLOPS、主記憶容量 2Gbyte)を、489台の48ポートギガビットイーサーネットスイッチで結合し、16×16×10構成の 3次元ハイパクロスバ結合網を構築しています。単一ノードのローカルディスクは 2台の160Gbyte のディスクで RAID-1構成となっており、総容量400Tbyte の分散磁気ディスクとして利用できます。

オペレーティングシステムはLinuxであり、クラスタミドルウェアとしてSCoreを利用しています。プログラミング言語はFORTRAN90、C及びC++で、MPIによる並列化を行っています。

PACS-CSの稼動状況は、常時パフォーマンスモニタにジョブの実行状況と温度が表示されるとともに、遠隔監視システムによって計算機、空調及び計算機室の温湿度が監視されています。

さらに詳しく知りたい方はPACS-CSプロジェクトをご覧下さい。